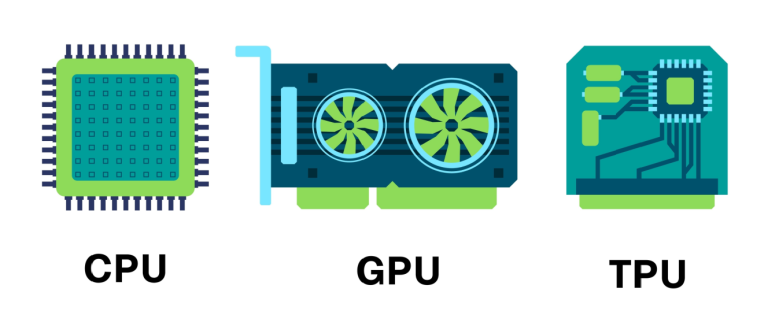

Os sistemas modernos não enfrentam apenas a pressão por desempenho, mas também lidam com demandas que se tornaram profundamente distintas entre si. Enquanto algumas aplicações dependem de decisões rápidas, acesso constante à memória e fluxos imprevisíveis, outras se apoiam em milhões de operações idênticas ou em cálculos matemáticos que só fazem sentido quando tratados como tensores. Nesse cenário, a discussão sobre CPU, GPU e TPU deixou de girar em torno de potência bruta e passou a considerar o tipo de trabalho que cada tecnologia realiza melhor.

Como cada uma sustenta uma lógica própria de processamento, entender essas diferenças permite alinhar capacidade, eficiência e propósito de forma muito mais precisa. Além disso, esse olhar ajuda a evitar escolhas genéricas e revela onde cada tecnologia realmente entrega vantagem, seja em tarefas sequenciais, em paralelismo intenso ou em cálculos estruturados como tensores.

A versatilidade das CPUs em tarefas variadas

As CPUs (Central Processing Unit) continuam na base dos sistemas de processamento porque lidam muito bem com tarefas diferentes ao mesmo tempo, mesmo processando quantidades moderadas de dados. Além disso, elas executam operações que exigem lógica, controle de fluxo e decisões rápidas, o que as torna indispensáveis para sistemas operacionais, bancos de dados e aplicações de negócios. Ainda que mantenham essa versatilidade, as CPUs encontram limites naturais quando a carga de trabalho envolve milhares de operações repetitivas sobre conjuntos de dados muito grandes.

Entretanto, em ambientes que dependem de paralelismo intenso, a CPU perde eficiência, porque seus poucos núcleos foram projetados para flexibilidade e não para executar a mesma instrução milhares de vezes em paralelo. Por isso, cargas altamente repetitivas ou matematicamente pesadas tendem a migrar para arquiteturas mais especializadas.

A força do paralelismo massivo nas GPUs

As GPUs (Graphics Processing Unit) surgiram para acelerar gráficos, mas rapidamente ultrapassaram essa função. Hoje, elas se destacam por executar grandes volumes de dados sob um mesmo padrão de instruções, seguindo modelos de paralelismo como SIMD (Single Instruction, Multiple Data). Essa arquitetura, formada por muitos núcleos simples e altamente paralelos, sustenta desde renderização e simulações até processamento de imagem e vídeo.

Com a expansão da inteligência artificial, as GPUs se tornaram essenciais, porque treinam redes neurais e manipulam lotes enormes de dados de forma muito mais eficiente que CPUs. Ainda assim, como foram construídas para repetir uma mesma operação em escala, elas não oferecem o mesmo desempenho em cargas que exigem decisões complexas ou lógicas variadas. Dessa forma, CPU e GPU se complementam e raramente competem entre si.

A especialização matemática das TPUs

As TPUs (Tensor Processing Unit) surgiram para resolver um desafio específico: acelerar cálculos de aprendizado de máquina. Elas foram projetadas para executar operações matemáticas sobre tensores, que são matrizes e arrays multidimensionais, com altíssima eficiência. Como grande parte do machine learning se baseia em multiplicações matriciais e convoluções, as TPUs concentram sua arquitetura em unidades dedicadas a esse tipo de cálculo.

Embora tenham sido introduzidas originalmente pelo Google, hoje existem fabricantes asiáticas produzindo aceleradores com propostas semelhantes, impulsionadas pela corrida global por chips de IA. Além disso, o design orientado a ASIC (Application-Specific Integrated Circuits) torna as TPUs extremamente eficientes em energia e desempenho, porém pouco flexíveis fora do universo de tensores. Assim, elas brilham em tarefas altamente específicas, como treinamento e inferência em larga escala.

Como CPU, GPU e TPU se comparam na prática

Ao observar CPU, GPU e TPU lado a lado, fica claro que cada uma se destaca em um cenário diferente. A CPU funciona melhor quando o sistema precisa coordenar tarefas variadas, acessar memória de forma dinâmica ou executar lógicas complexas. A GPU entrega melhor desempenho quando a mesma operação se repete milhares de vezes sobre grandes volumes de dados. Já a TPU vence quando a tarefa envolve cálculos matriciais contínuos, típicos de modelos de aprendizado de máquina.

Além disso, a escolha entre essas tecnologias afeta diretamente o custo por operação, consumo energético e escalabilidade. Enquanto a CPU oferece flexibilidade, a GPU oferece paralelismo e a TPU oferece eficiência matemática direcionada. Dessa forma, a análise da carga de trabalho se torna o ponto de partida para qualquer decisão de compra.

Erros comuns que comprometem o desempenho

A escolha equivocada entre CPU, GPU e TPU ocorre com frequência, porque muitos profissionais avaliam apenas métricas superficiais, como frequência de clock ou quantidade de núcleos. Em alguns casos, empresas investem em GPUs acreditando que o paralelismo resolve qualquer gargalo, enquanto a aplicação depende mais de decisões sequenciais. Em outros cenários, projetos apostam em TPUs sem verificar compatibilidade com frameworks e bibliotecas, o que limita o uso e reduz a eficiência.

Por isso, observar a natureza do problema, seja ele baseado em lógica, paralelismo ou cálculos tensorais, reduz desperdícios e orienta investimentos com mais precisão.Assim, a compra deixa de responder ao hype e passa a refletir a realidade técnica do ambiente.

Conclusão: o processador certo para o problema certo

As diferenças entre CPU, GPU e TPU mostram que nenhuma arquitetura resolve todos os desafios da computação moderna. A CPU garante versatilidade, a GPU acelera tarefas paralelas e a TPU otimiza cálculos matemáticos de aprendizado de máquina. Além disso, a evolução recente de chips especializados, tanto de grandes empresas quanto de novos fabricantes asiáticos, indica que o mercado seguirá em direção a aceleradores cada vez mais específicos.

Por fim, escolher entre essas arquiteturas significa compreender a natureza da tarefa, o volume de dados e a forma como o sistema cresce ao longo do tempo. Quando a decisão respeita a lógica do problema, o hardware deixa de ser apenas um recurso e passa a orientar desempenho, eficiência e escala de maneira consistente.

Leonardo Salgado – VP Financeiro da AbraCloud – AbraCloud – Associação Brasileira de Infraestrutura e Serviços Cloud, e Diretor Financeiro na ADENTRO